逼真到恐怖,小姐姐挤眼挑眉五官乱飞,3D化身全新算法秒杀谷歌

逼真到恐怖,小姐姐挤眼挑眉五官乱飞,3D化身全新算法秒杀谷歌

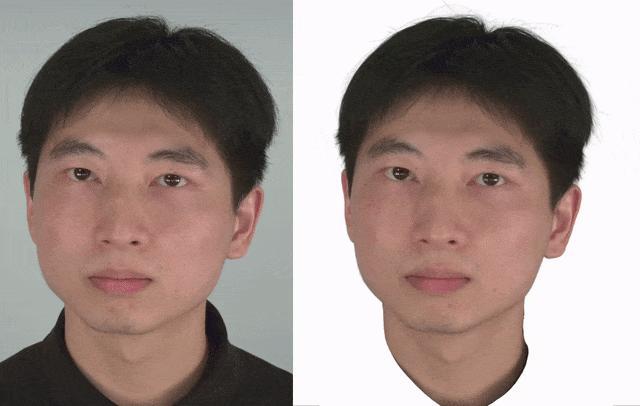

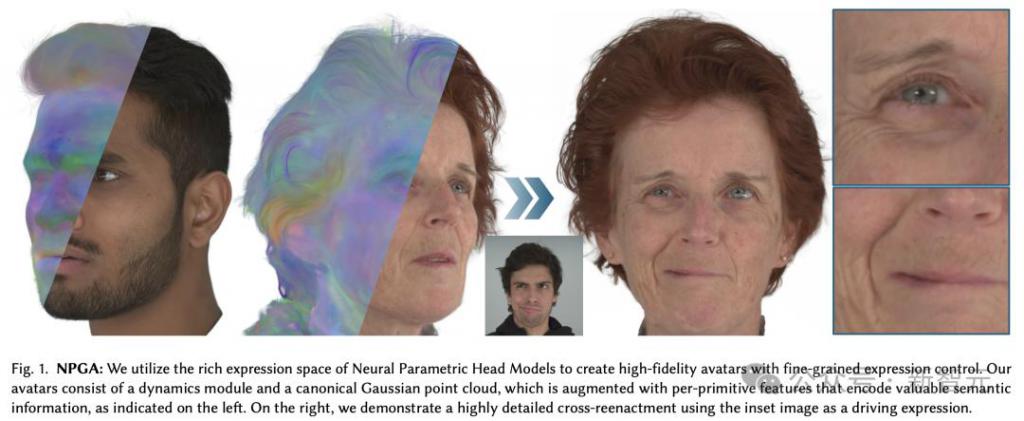

【导读】谁能想到,某天和你聊天的那个人竟是一个 AI。来自 TUM 等研究人员提出了一种全新算法 NPGA,能够生成高保真 3D 头像,表情逼真到让你怀疑自己的眼睛。

真正的恐怖谷效应是什么?

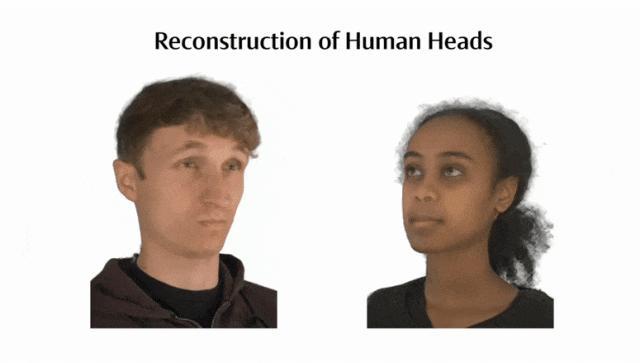

快看,下面这个女生做出了各种生动丰富的表情,挤眼,挑眉,嘟嘴 ....

再来看这个男孩,不停地变化嘴型,再加上细微的眼神动作,丝毫看不出来和我们有何区别。

然而,谁能想到,他们竟不是真人!

网友纷纷称其为 AGI,简直逼真到可怕。

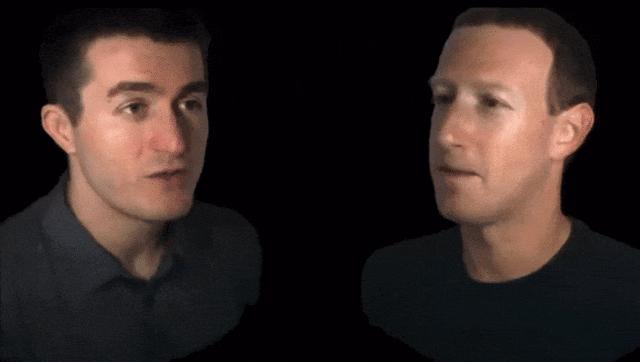

如此厉害的 3D 头像生成,完全不输小扎此前带着 Quest 3 Pro 做客「元宇宙」播客的逼真数字化身。

那么,这项研究竟出自哪位民间高手?

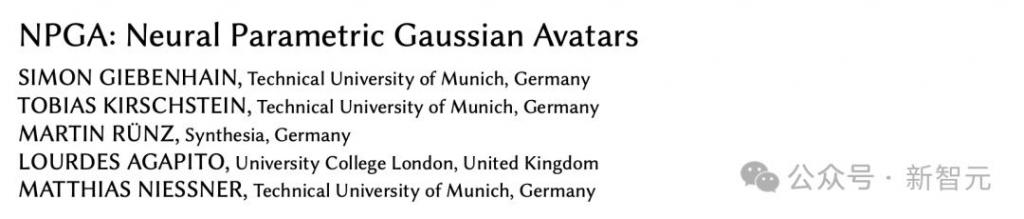

最近,来自德国慕尼黑工业大学、伦敦大学学院等研究团队提出了全新算法—— NPGA,可生成高质量 3D 头像。

论文地址:https://arxiv.org/pdf/2405.19331

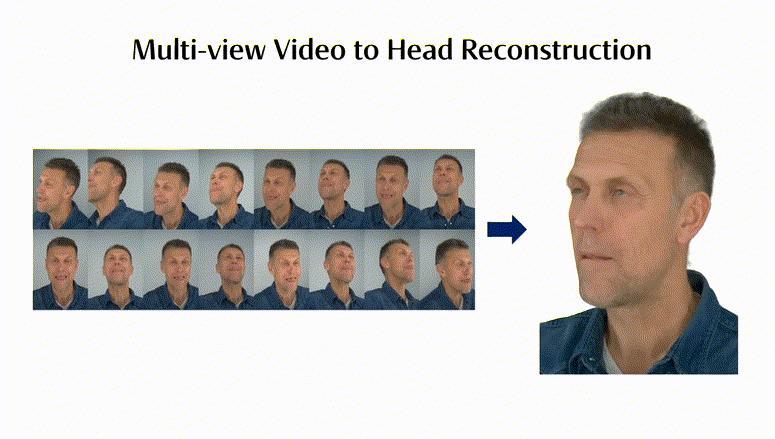

这是一种基于数据驱动的方法,从多视角的视频中创建出高保真、可控的虚拟化身。

传统上,往往会用网格 3DMM 去生成渲染的头像,但效果一般。

而 NPGA 的创新在于,采用了高斯点云的方式,即通过无数个点组成 3D 人像形状,让渲染更加高效、逼真。

另外,研究的另一个创新在于,利用了神经网络模型——「神经参数化头模型」(NPHM)来捕捉人脸细微表情的变化,由此 3D 数字化身可以更真实模拟人类表情。

最后,为了增强数字化身的表现力,研究人员还对潜在特征和预测动态提出了「拉普拉斯项」(Laplacian terms)。

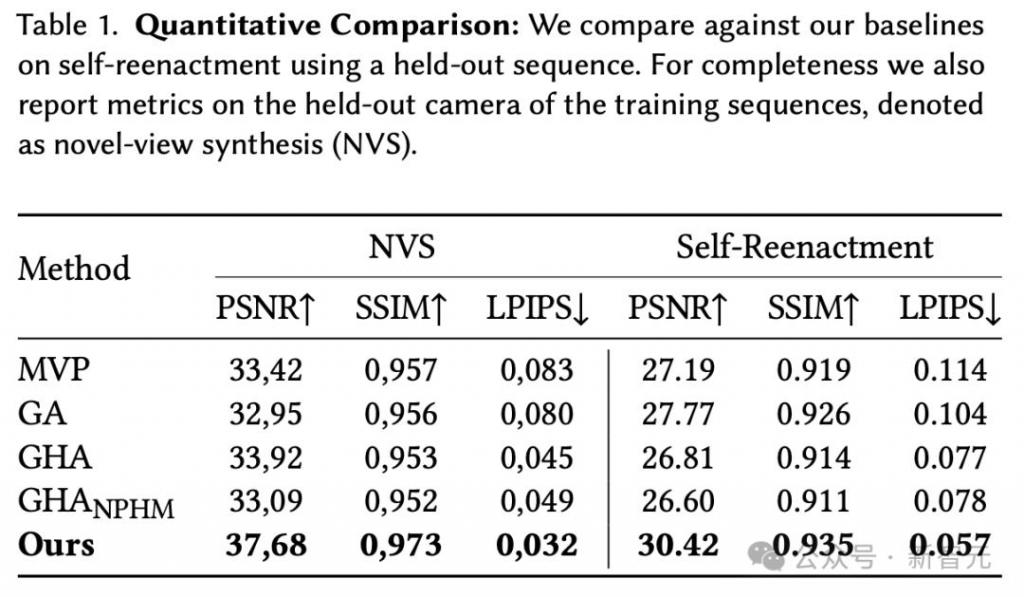

实验评估结果显示,NPGA 比起之前 SOTA 模型,在自我重现任务中,大约有 2.6PSNR 提升。

有人惊呼,这简直离诈骗又近了一步。

此时的网友还不忘调侃,谷歌最近放出的一个不可思议的视频。

看这奇怪的画风,再加上虚拟化身不稳定性,简直无法和 NPGA 竞争。

这是谷歌团队新提出的 ChatDirector 算法,按谷歌宣传的话称,3D 虚拟头像可以让在线会议更具「沉浸感」

NPGA:神经参数高斯化身

这项技术可以应用在很多场景,比如电影、游戏、AR/VR 远程会议,以及小扎心心念念的元宇宙。

虽然视频的效果看起来如此逼真,但其实,从现实世界捕获图像并重建 3D 头像是一个极具挑战性的课题。既需要计算机视觉(CV)准确的识别功能,也需要计算机图形学(CG)的高保真和实时渲染性能。

近年来这两项技术的交叉,让虚拟世界的 3D 化身越来越逼真。然而,有一个核心问题还没被解决——如何实现控制性。

谷歌 ChatDirector 的视频之所以十分奇怪,主要原因不在画面渲染,而在面部动作和表情的控制性差,说话时嘴动了但其他部位没有动,有「皮笑肉不笑」的感觉。

Reddit 评论区有网友发问,「我什么时候能看到这个模型的开源版本,这样只需要几张照片就能生成类似的 3D 化身了?」

很遗憾,目前的技术应该还做不到通过几张图片就能进行 3D 重建。

团队使用的训练集 NeRSemble 是一个视频数据集,用 16 个机位拍摄了 220 多个人体头部的 4700 多个高分辨率、高帧率的多视图视频,包含了各种丰富头部运动、情绪、表情和口语。

这个数据集同样由 NPGA 的作者团队发表于 2023 年,并被 SIGGRAPH 2023 和 ACM TOG 接收。

论文地址:https://tobias-kirschstein.github.io/nersemble/

温馨提示,想点进去看示例视频的话可能需要比较强大的心理素质,里面收录的各种夸张表情可以称之为人类抽象行为大赏。

去年刚发表数据集时,重建出来的动作和表情还比较僵硬,也没有丰富的面部细节。

短短一年时间就做到了如此逼真的效果,源于团队在方法上做出的改进。

方法概述

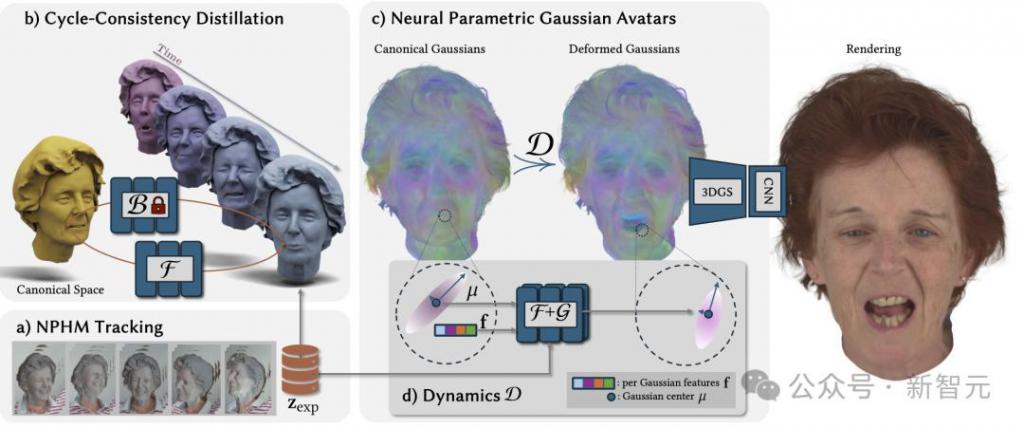

a ) 以 MonoNPHM 模型为基础,在 NeRSemble 数据集上使用 COLMAP 计算的点云追踪 MonoNPHM,从而实现几何精确的模型追踪。

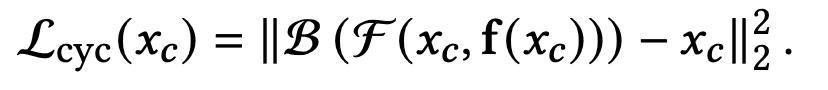

b ) 提出循环一致性目标来反转 MonoNPHM 的后向变形场,由此产生的前向变形场可以直接兼容基于光栅化的渲染。

c ) NPGA 由规范高斯点云和 MLP 组成,包含蒸馏过的先验网络 F 进行前向变形,以及网络 G 学习细粒度的动态细节。

d ) 通过为每个基元(primitive)附加潜在特征,将变形场的输入提升到一个更高维的空间,从而可以更准确地描述每个基元的变形行为。

具体算法细节

之前的头部重建工作大多会使用 3D 可形变模型(3D Morphable Model),使用主成分分析(PCA)学习人体几何图形的表示,将面部识别和表情变化的参数空间分开。

尽管 3DMM 的参数空间足够紧凑,但论文作者认为,其底层的线性本质限制了表达空间能够实现的保真度。

论文同时表示,底层表达空间对于虚拟人的质量有至关重要的作用,不仅影响可控性,而且决定细节清晰度的上限。如果底层的表达不充分,很有可能在优化模型时导致过拟合。

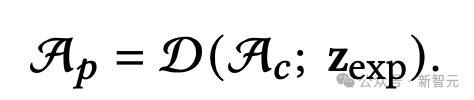

因此,团队使用了 3DMM 的改进版—— NPHM(Neural Parametric Head Models,神经参数化头部模型),从多视角的图像序列中追踪并提取身份识别的隐向量 z_id 和表情代码 z_exp。

之后,就可以用一个后向变形场 B,将姿势空间中的点 x_p 转换为规范空间中的坐标 x_c:

比较遗憾的是,这项研究只专注于重建头部,屏蔽了数据集中的躯干部分,因为没有包含在 NPHM 提取出的 z_exp 的表达空间内。

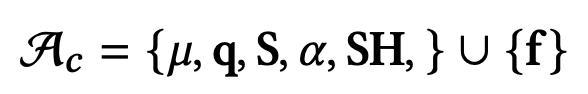

基于 3DGS 中的为每个基元定义的场景表示,作者额外添加了高斯特征

,虽然它本身是一个静态特征,但可以为每个基元的动态行为提供语义信息,起到了一种类似于位置编码的作用。

进行参数化表达后,论文提出的用于建模面部表情的动态模块 D 由 2 个多层感知器(MLP)组成:

- 基于粗略先验的网络 F

- 超越先验知识、负责建模剩余细节的网络 G

其中,模型 F 的训练和使用是这篇文章的核心创新之一。首先让 F 在 NeRSemble 数据集中 20 个人的图像序列上进行训练,之后会将这个网络运用在所有虚拟化身的重建中。

F 的先验知识,则通过「循环一致性蒸馏」的方法,从后向变形场 B 中提取(实质上是 B 的逆元).

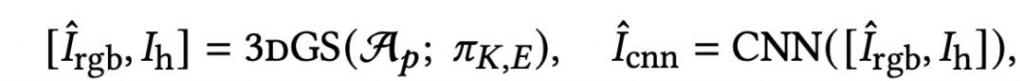

之后使用动态模型 D,就可以得到重建的姿势空间中的高斯点云表示 A_p:

基于 A_p 完成屏幕空间的渲染后,团队还提出使用一个 CNN 网络提升潜在图像的细节表达,取代了用超分辨率处理。之后的消融实验也证明了 CNN 对性能提升的有效性。

除了算法和架构的设计,团队也在优化策略上做了两处改进。

其一是对规范空间 A_c 与动态模型 D 进行基于 KNN 图算法的拉普拉斯平滑。

其二是自适应密度控制(Adaptive Density Control),这是 3DGS 成功的核心因素。使用启发式的方法,在静态场景下,对可能冗余的高斯点云密度进行剪枝处理。

实验评估

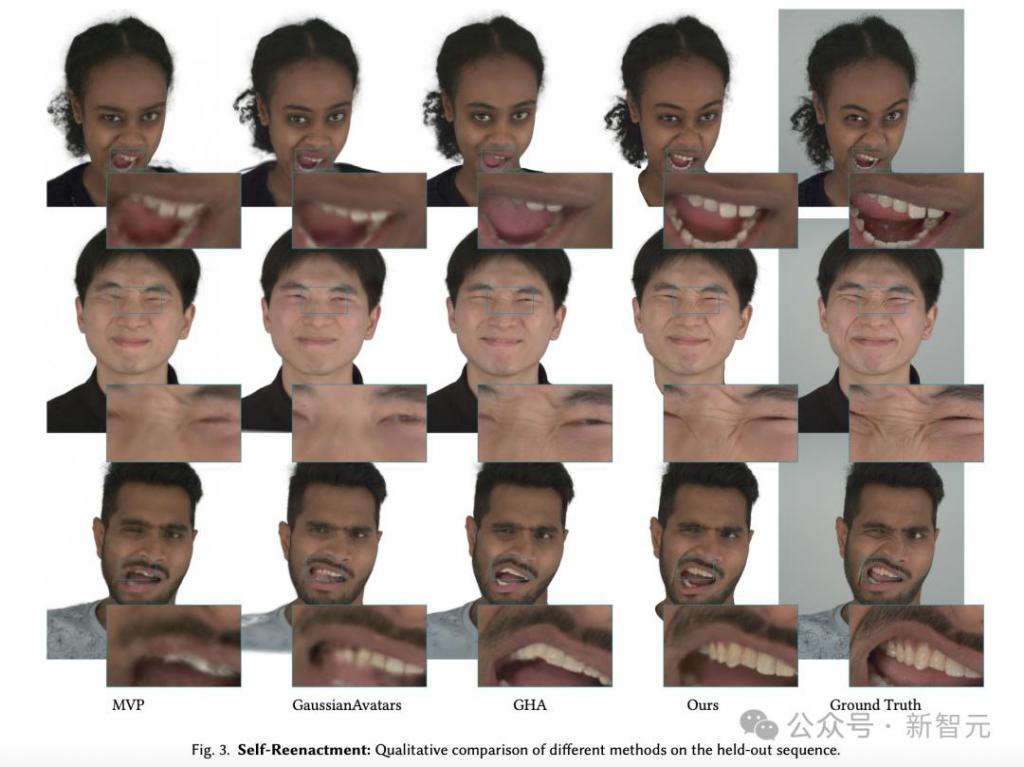

研究人员通过自我重现(Self-Reenactment)任务来评估 NPGA 算法的保真度。

自我重现会更准确地描绘出看不见的表情,并在头发区域等相对静态区域中,包含更清晰的细节。

有趣的是,GHA_NPHM 的性能比 GHA 稍差,这表明仅使用 MonoNPHM 表达代码,并不能立即提升性能。

相反,研究人员假设如果没有 NPHM 的运动作为初始化,NPHM 的潜在表达分布可能会,提供比 BFM 的线性混合形状更复杂的训练信号。

如下是,不同方法对保留序列的定性比较。

这些方法的定量结果如下。

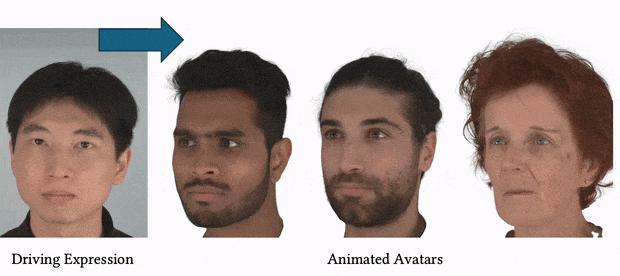

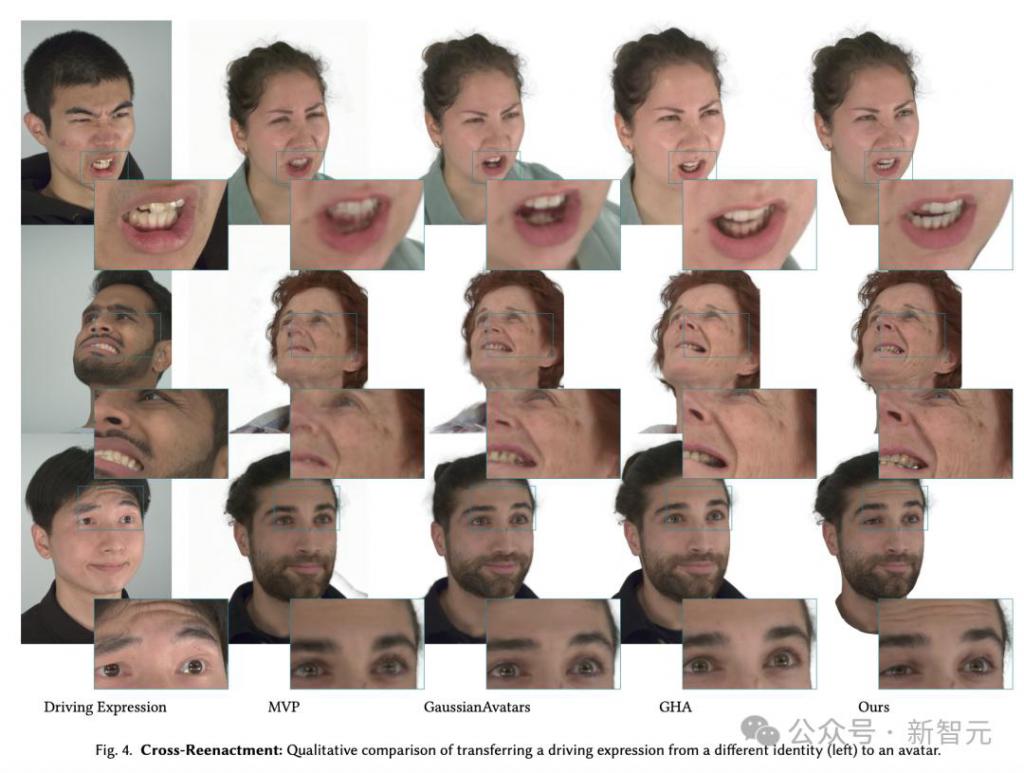

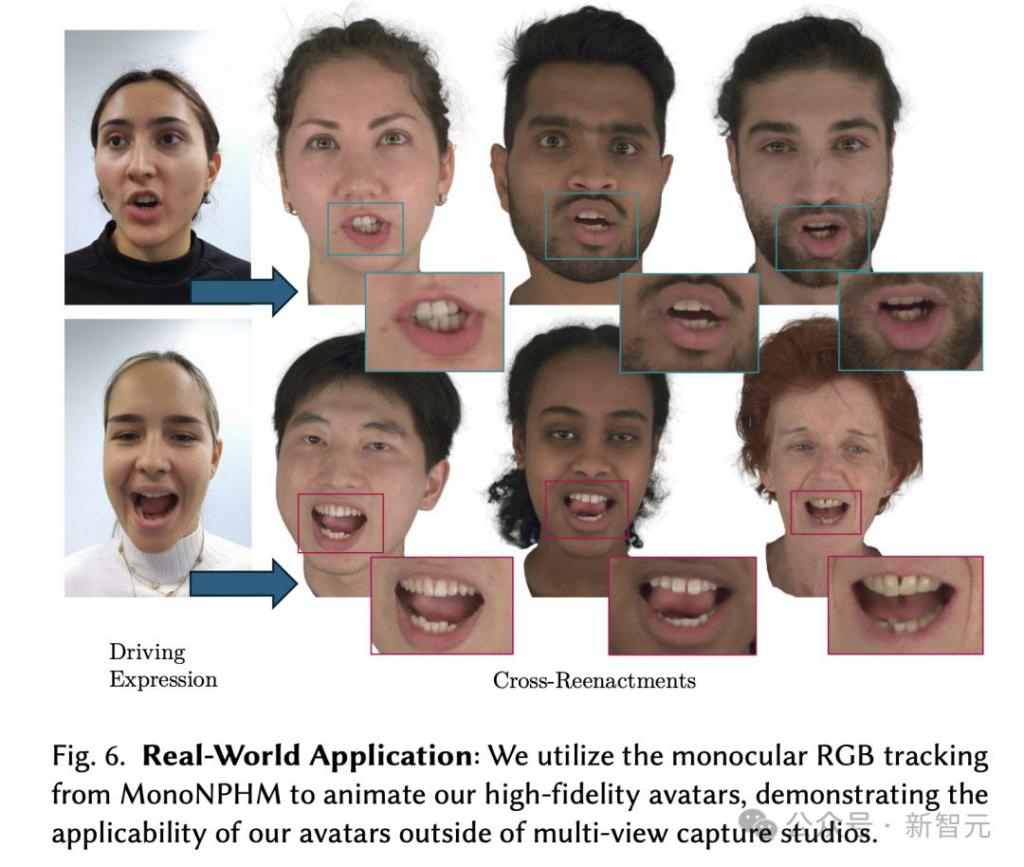

再来看,在交叉重现(cross-reenactment)任务中,全新算法的表现又如何?

交叉重现是指,将另一个人的表情转移到虚拟化身上。

如下图所示,所有的方法都成功将身份和表达信息分裂出来,从而实现了有效的交叉重现。

不过,NPGA 的化身保留了更多驱动表情的大部分细节。

为了证明算法的现实世界适用性,图 6 显示了,研究人员利用 MonoNPHM 的单目 RGB,来追踪高保真化身动画。

消融研究

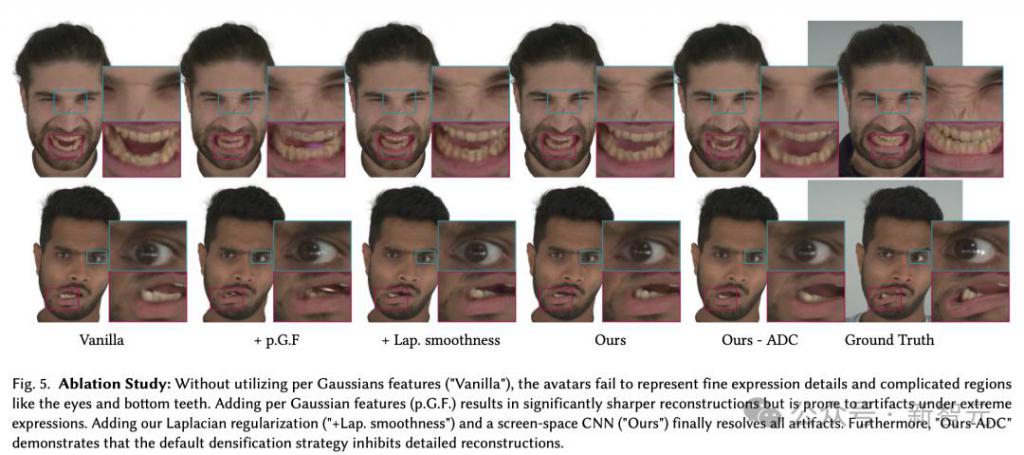

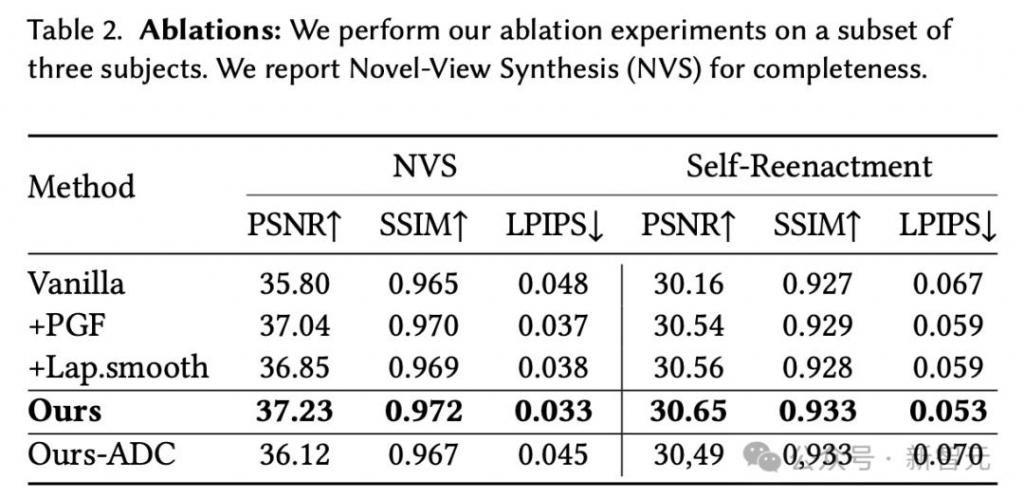

在最后的消融实验中,为了验证 NPGA 的几个重要组成部分,研究人员通过使用三个受试者进行了消融实验。消融的定量和定性结果分别见表 2 和图 5。

如果不利用全高斯特征(Vanilla),3D 头像就无法呈现出非常精细的表情,包括眼睛和下齿等复杂区域。

不过,在添加全高斯特征(p.G.F.)后,重建效果明显更清晰,但在极端表情下容易产生伪影。

当研究人员添加了拉普拉斯正则化和屏幕空间 CNN,最终解决这一伪影问题。

此外,实验还证明了,默认的点云密集化策略,会抑制细节的重建,因此使用自适应密度控制(ADC)的策略非常必要。

下表说明了,使用正则化策略可以显著缩小训练序列(NVS)和测试序列(自我重现任务)之间的泛化差距。

局限性

研究人员表示,NPGA 创建的虚拟化身的可控性、重建质量,从根本上讲,会受到底层 3DMM 表达空间的限制。

因此,包括颈部、躯干、舌头、眼珠旋转这些区域,无法用 NPHM 的表情代码来完全解释。

由此,算法无法可靠地进行动画处理,甚至可能因为过拟合而带来伪影。

目前可能的解决方案是,将底层 3DMM 扩展,提供对人类状态更详细的描述。

此外,NPGA 作为一种数据驱动的头像创建方法,在一定程度上受限于可用的数据。

-

- 大模型降价背后,国产大模型的竞争逻辑变了

-

2024-05-30 16:17:13

-

- 双榜下滑、TapTap评分6.5,网易新游《歧路旅人:大陆的霸者》数据如何?

-

2024-05-30 16:14:57

-

- 保时捷经销商“逼宫”,惊动宝马

-

2024-05-30 16:12:41

-

- 去了西藏后,俞敏洪对董宇辉一切都变了?

-

2024-05-30 16:10:26

-

- 小红书发力店播,商家会跟吗?

-

2024-05-30 16:08:10

-

- 当运营商开卷大模型:毫无亮点,没有新意

-

2024-05-30 16:05:54

-

- 中年男人最爱的贵价皮带,被奢侈品圈除名了

-

2024-05-30 16:03:37

-

- 微信张小龙最忌惮的人,要坚持不住了?

-

2024-05-30 16:01:22

-

- 2024年,大火的瑜伽裤赛道容得下新玩家吗?

-

2024-05-30 15:59:06

-

- 小杨哥消失,李佳琦喊“难”,头部主播618众生相

-

2024-05-30 15:56:49

-

- 反向旅游,已经不能满足年轻人了

-

2024-05-27 19:25:58

-

- 伊朗总统莱希直升机失事后的72小时

-

2024-05-27 19:23:42

-

- 背诗免景区门票!参考答案汇总→快收藏!

-

2024-05-27 19:21:27

-

- 大模型时代的AB面:大厂急商战,中小企业忙落地

-

2024-05-27 19:19:11

-

- 普通食品包装成“神药” 涉老保健品虚假宣传何时休?

-

2024-05-27 19:16:55

-

- AI PC成为马良的“神笔”,让NPC成为“赛博话唠”

-

2024-05-27 19:14:39

-

- 王小川:大模型价格战会加速泡沫周期,我们做C端的就别掺合了

-

2024-05-27 19:12:23

-

- 微软一夜干翻苹果!史上最强AI PC诞生,全面整合GPT-4o,能对话,还能教你打

-

2024-05-27 19:10:07

-

- 小鹏的压力,还得靠AI来解?

-

2024-05-27 19:07:51

-

- 浙江购房团狙击杭州“老破小”

-

2024-05-27 19:05:35

贵州两落马女厅官出镜忏悔:一人想念父母做的菜;一人带衣服投案

贵州两落马女厅官出镜忏悔:一人想念父母做的菜;一人带衣服投案 北京等地上空疑现不明飞行物!目击网友称“飞着飞着就没了”

北京等地上空疑现不明飞行物!目击网友称“飞着飞着就没了” 毛戈平7年IPO折戟,国货化妆品的出路在哪里

毛戈平7年IPO折戟,国货化妆品的出路在哪里 苹果Vision Pro,被华强北啃了

苹果Vision Pro,被华强北啃了 中产捧红的始祖鸟即将IPO,安踏捧出第二个“FILA”?

中产捧红的始祖鸟即将IPO,安踏捧出第二个“FILA”? 不想过年的年轻人,躲回工作中

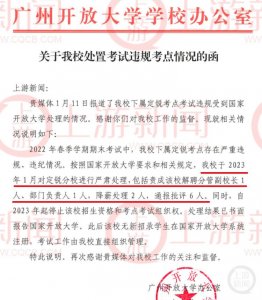

不想过年的年轻人,躲回工作中 2831人考试2093人次替考!广州开放大学分管副校长解聘

2831人考试2093人次替考!广州开放大学分管副校长解聘 大模型浪潮不能使鬼推磨,但可以让周鸿祎、傅盛握手言和

大模型浪潮不能使鬼推磨,但可以让周鸿祎、傅盛握手言和 嘉行传媒还“行”不“行”?

嘉行传媒还“行”不“行”? 红薯原产地是哪个国家 红薯原产地是哪个国家或地区生产的

红薯原产地是哪个国家 红薯原产地是哪个国家或地区生产的