大模型 2024:先把价格打下去

大模型 2024:先把价格打下去

AI 新星 OpenAI 最近有点头疼,不仅公司和 CEO 被马斯克起诉,其拳头产品 GPT-4 在性能和价格上均面临竞争对手的冲击。

近期,成立不到一年的法国人工智能创企 Mistral AI 发布了最新大模型 Mistral Large,并推出了首个聊天机器人产品 Le Chat,直接对标 ChatGPT。据了解,Mistral Large 在目前所有能通过 API 访问的大模型中评分第二,仅次于 GPT-4。

更值得关注的是,Mistral AI 还与微软达成了更加深入的合作协议,微软将投资入股 Mistral AI,并为其提供算力和云服务,而 Mistral AI 的大模型资源也将在微软的 Azure 云平台中售卖。要知道,上一个有此待遇的 AI 创业公司还是 OpenAI。

除此之外,更低廉的 API 接口价格也让 Mistral Large 成为了 GPT-4 的有力竞争者,并有望在当前的大模型军备竞赛中掀起一场价格战。

比 GPT-4 更具性价比?

作为一款诞生于欧洲的大模型,Mistral Large 支持英语、法语、西班牙语、德语和意大利语,可深度理解语法和文化背景。另外,Mistral Large 的上下文窗口为 32K,可从约 2.4 万个英文单词的大型文档中精准提取信息;具备精确的指令跟随能力,便于开发者定制审核策略;支持原生函数调用和限定输出模式,助力应用开发规模化和技术栈现代化。

性能方面,虽然 Mistral AI 并未公布 Mistral Large 的参数量,但其关键性能已达到业界前三。

具体来看,Mistral Large 在 MMLU 基准测试中的常识和推理得分为 81.2%,仅次于 GPT-4 的 86.4%。Mistral Large 达到了顶级的推理能力,可用于复杂的多语言推理任务,包括文本理解、转换和代码生成。其推理准确性优于 Anthropic 的 Claude 2、谷歌的 Gemini 1.0 Pro、OpenAI 的 GPT-3.5,推理速度甚至超过了 GPT-4 和 Gemini Pro,显示了其在处理复杂任务时的高效能力。

多语言能力测试中,Mistral Large 在法语、德语、西班牙语和意大利语的 Arc Challenge、HellaSwag、MMLU 等基准测试中的表现均远超目前公认最强的开源大模型—— Meta 的 LLaMA 2 70B。

数学和编程能力方面,Mistral Large 同样表现不俗:其在 MBPP 基准测试中的编程得分高于 LLaMA 2 70B,在 Math maj@4 基准测试中的数学得分也领先于 GPT-3.5、Gemini Pro 1.0 等模型。

作为 Mistral AI 商用系列中的旗舰模型,Mistral Large 与 GPT-4 一样并未开源。用户可通过三种方式访问与使用 Mistral 模型:其中,在欧洲的 Mistral Al 基础设施上安全托管的 La Plateforme 是开发者访问 Mistral Al 所有模型的首选方式,开发者可通过点击创建自己的应用程序和服务;Mistral Al 的开源模型目前可通过 GCP、AWS、Azure、NVIDIA 等云服务商获得,而 Mistral Large 目前仅通过 Azure 云平台提供服务,包括 Azure AI Studio 和 Azure Machine Learning。

此外,开发者还可以通过虚拟云或 on-prem 自行部署使用 Mistral 模型,这种方式提供了更高级的自定义和控制,自有数据将保留在公司内部。

价格方面,目前上下文窗口为 128k 的 GPT-4 Turbo 的输入价格为 0.01 美元 /1000 token,输出价格为 0.03 美元 /1000 token。相比之下,Mistral Large 的输入、输出价格均为前者的 80%。

体验方面,有 AI 创业者指出,Mistral Large 的使用体验碾压曾经的第三名 Claude 2。截至 2023 年 11 月,OpenAI 的开发者规模达 200 万,其中包含 92% 的世界 500 强企业。而 Mistral Large 直逼 GPT-4 的性能和更低的售价有望为需求量巨大的企业用户节省一大笔开支,从被 OpenAI 垄断的 MaaS(模型即服务)市场撕开一个口子。

MoE 架构立大功

Mistral Large 把价格打下来的底气是更低的训练成本。OpenAI CEO Sam Altman 曾表示,GPT-4 的模型训练成本 " 远远超过了 "5000 万至 1 亿美元。而据 Mistral AI 创始人 Arthur Mensch 透露,Mistral Large 的训练成本不到 2200 万美元,约为 GPT-4 的五分之一。

除了真金白银的训练成本,后来者居上的 Mistral Large 的时间成本也更具优势。OpenAI 从成立到推出 GPT-4,足足用了 8 年,而 Mistral AI 推出仅次于 GPT-4 的 Mistral Large 只用了 9 个月。

Mistral AI 号称欧洲版 OpenAI,创始团队由 Meta 和 Deepmind 的前科学家们组成。成立后的半年多时间里,Mistral AI 接连完成 1.05 亿欧元种子轮融资和后续的 4.15 亿欧元融资,得到美国光速、a16z 等顶级 VC 以及英伟达、赛富时、法巴银行的青睐。

同期,Mistral AI 先后推出号称当时 " 最强的 70 亿参数开源模型 "Mistral 7B、首个开源 MoE 大模型 Mistral 8x7B。其中,Mistral 8x7B 更是以一条简单粗暴的磁力链接引领了大模型发布的新范式,给业界带来震撼。

凭借巨额融资叠加新品发布,Mistral AI 的估值也曾一夜之间飙升至 20 亿美元,成为大模型领域的新晋独角兽。而 Mistral AI 更引人关注的是,从初期只有 6 人的小团队成长至今,Mistral AI 一直是 MoE 路线的忠实信徒。

MoE 即 " 混合专家模型 ",这种模型设计策略通过将大模型分解为多个子模块,提高模型的容量、处理能力和效率。MoE 架构主要由 " 专家 " 和门控机制两部分构成。每个 " 专家 " 相当于一个小型的 Transformer 模型,专门处理特定类型的输入数据,多个 " 专家 " 的结合则使模型具备了更好的性能。而门控机制则用于判定输入样本需由哪些 " 专家 " 接管处理。

大模型的大规模应用与其算力成本紧密相关。对于模型厂商而言,目前主要的算力成本包括预训练成本和推理成本。除去 GPU 每秒运算次数和显卡的租用成本这两个常量后,大模型的预训练成本与模型参数量和训练数据的 token 量正相关,推理成本与模型参数量正相关。而大模型的性能通常与其参数量相关联,而越高的参数量意味着越高的算力成本。因此,如何在同样的算力成本下提升大模型的参数量成了破局的关键。

而 MoE 的解题思路是引入稀疏性,即模型训练过程中,各有所长的 " 专家 " 们独立训练、各司其职,在过滤重复信息、减少数据干扰的同时大幅提升模型的学习速度与泛化能力;在推理过程中,每次推理只按需调用部分 " 专家 ",激活其对应的部分参数,如此便有效降低了相同参数下大模型的算力成本。

有意思的是,OpenAI 在去年成为 " 当红炸子鸡 " 成功得到众多重度用户的续费后,被曝采用 MOE 重新设计了 GPT-4 构架,导致性能受到影响。尽管 OpenAI 官方并未对此进行正面回应,但利用 MOE 架构降低训练成本,已经被认为是一个无比自然的发展方向。

Mistral AI 同样未公布大模型的具体参数与训练数据 Token 数,但此前谷歌应用 MoE 开发出的 GLaM 模型参数量达 12000 亿、训练数据 16000 亿 token,分别是 GPT-3.5 的 6.8 倍和 5.3 倍,其实际的训练成本却只有 GPT-3.5 的三分之一也印证了 MoE 框架的高效。

延续着 MoE 的路线,如果说此前发布的开源模型 Mistral 7B、Mistral 8x7B 实现了对 LLaMA 等大参数开源模型的逆袭,此次发布的 Mistral Large 则是 Mistral AI 对可持续商业模式的探索,试图以闭源模型搭建可盈利的产品线。

大模型进入成本战

顶着对华芯片禁售的压力,芯片巨头英伟达以一份耀眼的四季报打消了市场顾虑:在数据中心与游戏业务双核驱动下,英伟达 2023 年四季度营收、净利润大幅超出预期,毛利率再创历史新高。业绩加持下,英伟达业绩已突破 2 万亿美元,更接连超越亚马逊、沙特阿美,成为仅次于微软和苹果的全球第三大公司。

数据、算力和算法构成了大模型的基石。在当下这波如火如荼的大模型淘金热中,从学界到初创企业再到巨头纷纷下场,而无论其技术路线是开源或闭源,应用场景是通用或垂直,AI 芯片作为大模型大脑,始终是模型预训练和推理必不可少的工具。

身为高端 GPU 市场中唯一的提供方," 军火商 " 英伟达是这场大模型军备竞赛中永远的赢家——以 A100 为例,若要通过训练达到 ChatGPT 级别的性能,至少消耗一万张 A100 加速卡,巨头们囤货的单位也以万张起,怎能不赚得盆满钵满?

但换个角度来看,在 GPU 供应短缺的背景下,一张 A100 显卡售价约 10000 美元甚至更高,对于大模型厂商来说,在应用落地和商业化前景仍不明朗的情况下,动辄上亿美元真金白银的投入必然肉疼。在算力、数据、人力等资源成本高企的情况下,如何用相对低的成本训练出一个想要的大模型,并以一个用户可接受的成本让大模型跑起来是大模型行业在 2024 年的当务之急。

在保证同等效果前提下,提高硬件利用率,缩短算力使用时长;优化工具链以提高训练、推理效率;适配低价 GPU 是当前国内大模型厂商降本的主流方法论。

例如,面向大模型训练,腾讯升级了自研机器学习框架 Angel,针对预训练、模型精调和强化学习等全流程进行了加速和优化,提升了内存的利用率。借此,大模型训练效率可提升至主流开源框架的 2.6 倍,用该框架训练千亿级大模型可节省 50% 算力成本,大模型推理速度提高了 1.3 倍。

京东云推出 vGPU 池化方案,提供一站式 GPU 算力池化能力,结合算力的任意切分和按需分配,在同等 GPU 数量的前提下,实现了数倍业务量扩展和资源共享,降低了硬件采购成本,使用更少的 AI 芯片支撑了更多的训练和推理任务,GPU 利用率最高提升 70%,大幅降低大模型推理成本。

阿里云通义大模型则聚焦于规模定理,基于小模型数据分布、规则和配比,研究大规模参数下如何提升模型能力,并通过对底层集群的优化,将模型训练效率提升了 30%,训练稳定性提升了 15%。

百度升级了异构计算平台 " 百舸 ",将训练和推理场景的吞吐量提高了 30%-60%,意味着原先需要用 100 天的训练才能达成的效果,现在只需 40-70 天,节约时间等于间接省钱。同时,在英伟达之外,百度的 " 千帆 " 大模型平台还兼容昆仑芯、昇腾、海光 DCU、英特尔等国内外其他主流 AI 芯片,通过组合选项完成低成本的算力适配。

正所谓 " 早买早享受,晚买有折扣。" 当前,Mistral AI 以性价比暂时领先,但也有不少开发者还在等待 OpenAI 大模型产品的升级降价。毕竟,正是 OpenAI 自己在 GPT-4 发布后不到 8 个月就推出了更强也更便宜的 GPT-4 Turbo。

来源:惊蛰研究所

-

- 这件事,刻不容缓

-

2024-03-12 21:36:33

-

- 阿里又在AI上大出血了

-

2024-03-12 21:34:17

-

- 阿里为何投资了这么多大模型?

-

2024-03-12 21:32:01

-

- 月薪5000元,看不起付费短剧

-

2024-03-12 21:29:46

-

- 从“瓶子到积木”计划失败 ,玩具巨头乐高可持续发展表现如何?

-

2024-03-12 21:27:30

-

- 理想MEGA战败,不能全赖黑公关

-

2024-03-12 21:25:14

-

- 外国亲戚正在掀起一股来华旅游潮

-

2024-03-12 21:22:57

-

- 课间10分钟能否改为半小时?

-

2024-03-12 02:03:09

-

- 李想拿什么拯救MEGA?

-

2024-03-12 02:00:51

-

- 内燃机专业毕业生的困惑:新能源时代抛弃了我们?

-

2024-03-12 01:58:34

-

- 一个D轮独角兽宣布破产

-

2024-03-12 01:56:17

-

- 这次TikTok真的危险了

-

2024-03-12 01:54:00

-

- Sora还没开源,但这家国产AIGC视频公司已经靠还原现实赚钱了

-

2024-03-12 01:51:43

-

- 日本公务员穷疯?为200块生活费连夜偷14个井盖、上班写小说糊口,网友:铁饭

-

2024-03-12 01:49:26

-

- 苹果只剩降价一条路

-

2024-03-12 01:47:09

-

- 特斯拉、英伟达投身其中,人形机器人能借AI风口起飞吗?

-

2024-03-12 01:44:52

-

- 塞斯纳A-37“蜻蜓”攻击机 越南战场的另类机型 如今执行禁毒任务

-

2024-03-12 01:42:35

-

- “新能源汽车第一城”再易主,深圳大幅超车,还有这些城市在踩油门

-

2024-03-09 16:11:04

-

- 3000点之后,“命好”的人开始赚钱了

-

2024-03-09 16:08:48

-

- 抖音能打,不代表TikTok是出海好搭子

-

2024-03-09 16:06:32

苹果Vision Pro,被华强北啃了

苹果Vision Pro,被华强北啃了 北京等地上空疑现不明飞行物!目击网友称“飞着飞着就没了”

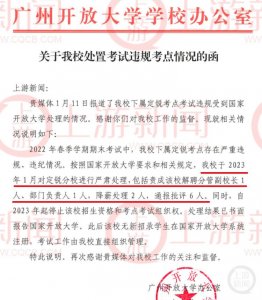

北京等地上空疑现不明飞行物!目击网友称“飞着飞着就没了” 2831人考试2093人次替考!广州开放大学分管副校长解聘

2831人考试2093人次替考!广州开放大学分管副校长解聘 毛戈平7年IPO折戟,国货化妆品的出路在哪里

毛戈平7年IPO折戟,国货化妆品的出路在哪里 不想过年的年轻人,躲回工作中

不想过年的年轻人,躲回工作中 荣耀赵明:Magic6要在体验上超越iPhone而不是参数上

荣耀赵明:Magic6要在体验上超越iPhone而不是参数上 大模型浪潮不能使鬼推磨,但可以让周鸿祎、傅盛握手言和

大模型浪潮不能使鬼推磨,但可以让周鸿祎、傅盛握手言和 对伏是什么意思 伏的意思是什么

对伏是什么意思 伏的意思是什么 嘉行传媒还“行”不“行”?

嘉行传媒还“行”不“行”? 中产捧红的始祖鸟即将IPO,安踏捧出第二个“FILA”?

中产捧红的始祖鸟即将IPO,安踏捧出第二个“FILA”?